Кодування тексту в компʼютерах

У комп’ютері вся інформація зберігається у вигляді нулів і одиниць. Щоб зберігати текстову інформацію, нам потрібне кодування, яке перетворює текст на нулі та одиниці. У 60-х роках ХХ століття для цього була створена таблиця ASCII, яка присвоювала символам числа від 0 до 255, а потім ці числа записували у двійковій системі в один байт.

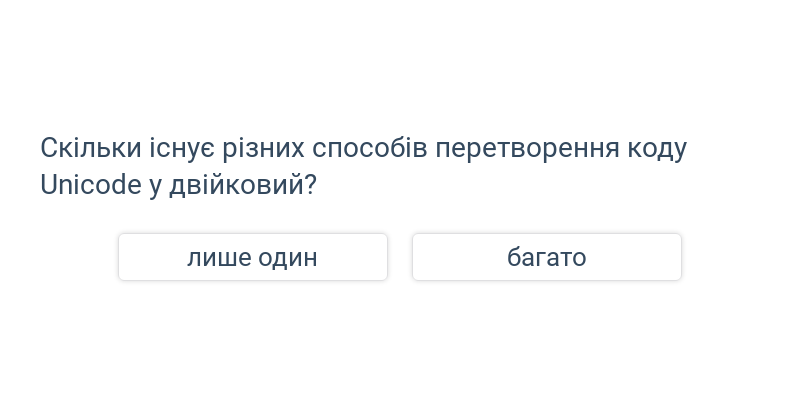

Однак ASCII дозволяло кодувати лише літери англійського алфавіту та деякі інші базові символи. Тому пізніше був розроблений стандарт Unicode, який дозволяє писати не лише основні літери, а й літери інших світових алфавітів та багато інших символів (як-от, символ сніговика: ☃). Ви можете дізнатися, які інші символи є в Unicode тут. У той час як Unicode призначає цифри символам, різні кодування (наприклад, UTF-8) визначають, як конвертувати ці числа в одиниці та нулі для збереження на комп’ютері.

Напр., Unicode кодує сніговика як число 2603 у шістнадцятковій системі. UTF-8 кодує це число у три байти зі значеннями 11 100 010, 10 011 000 і 10 000 011.

Вибір

Швидке практикування шляхом вибору з двох варіантів.